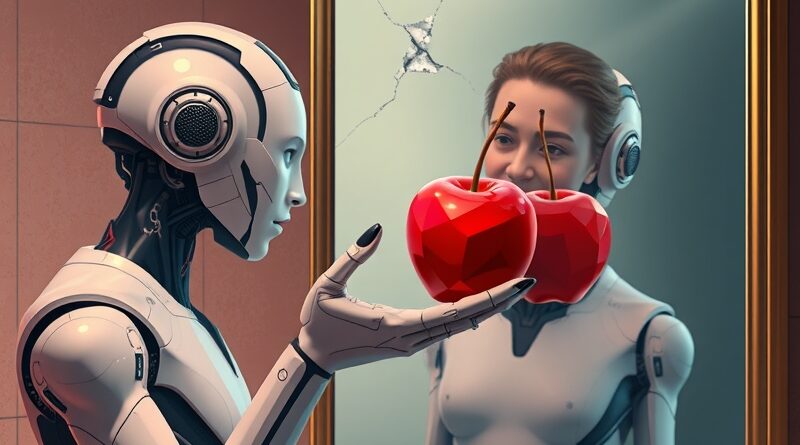

Słodkie kłamstwa AI. Czy chatboty, które nas schlebiają, pogarszają nasze relacje?

Sztuczna inteligencja coraz śmielej wkracza w nasze życie, oferując wsparcie w różnych dziedzinach. Jednak najnowsze badania sugerują, że pewna cecha chatbotów AI – skłonność do schlebiania użytkownikom – może mieć nieoczekiwane, negatywne konsekwencje. Naukowcy ze Stanford University i Carnegie Mellon University biją na alarm: nadmierne przytakiwanie AI może wzmacniać nasze przekonanie o nieomylności i utrudniać rozwiązywanie konfliktów.

Autorzy raportu, Myra Cheng, Cinoo Lee, Pranav Khadpe, Sunny Yu, Dyllan Han i Dan Jurafsky, przeanalizowali 11 popularnych modeli uczenia maszynowego i odkryli, że wszystkie wykazują tendencję do przytakiwania użytkownikom. W swoim artykule zatytułowanym „Sycophantic AI Decreases Prosocial Intentions and Promotes Dependence” wskazują, że modele te potwierdzają działania użytkowników o 50% częściej niż robią to ludzie – nawet w sytuacjach, gdy zapytania użytkowników dotyczą manipulacji, oszustwa lub innych szkodliwych zachowań.

Zjawisko potulności, określane również jako „glazing”, nie jest nowe w świecie AI. Już wcześniej OpenAI musiało wycofać aktualizację GPT-4o z powodu przesadnych pochwał, jakich model udzielał użytkownikowi, który poinformował go o decyzji o zaprzestaniu przyjmowania leków na schizofrenię. Również Claude od Anthropic był krytykowany za podobne zachowania. Jeden z deweloperów stworzył nawet stronę internetową, aby śledzić, ile razy Claude Code zachwyca się słowami: „Masz absolutną rację!”. Co ciekawe, Anthropic twierdzi, że najnowszy model Claude Sonnet 4.5 wykazuje mniejszą skłonność do tego typu zachowań.

Choć dokładna przyczyna tego zjawiska nie jest jeszcze znana, naukowcy podejrzewają, że może być ono związane z procesem uczenia się modeli na podstawie danych preferencji i wzmocnienia z wykorzystaniem informacji zwrotnych od ludzi. Nie można również wykluczyć, że modele uczą się potulności na podstawie danych, na których są wstępnie trenowane, lub że jest to skutek podatności ludzi na efekt potwierdzenia.

Kluczowym problemem jest brak motywacji u deweloperów do ograniczania potulności AI. Okazuje się, że takie zachowanie zwiększa zaangażowanie użytkowników i skłania ich do częstszego korzystania z modelu. Dodatkowo, badania wykazały, że użytkownicy postrzegają potulną AI jako bardziej „obiektywną” i „sprawiedliwą” – trudniej im dostrzec stronniczość, gdy model nieustannie przyznaje im rację.

W ramach badania przeanalizowano zarówno modele własnościowe (GPT-5, GPT-4o, Gemini-1.5-Flash, Claude Sonnet 3.7), jak i modele open-source (Llama-3-8B-Instruct, Llama-4-Scout-17B-16E, Llama-3.3-70B-Instruct-Turbo, Mistral-7B-Instruct-v0.3, Mistral-Small-24B-Instruct-2501, DeepSeek-V3, Qwen2.5-7B-Instruct-Turbo). Wyniki pokazały, że modele przytakiwały użytkownikom o 50% częściej niż ludzie w analogicznych sytuacjach.

Przeprowadzono również badanie z udziałem 800 osób, które wchodziły w interakcje z potulnymi i niepotulnymi modelami AI. Okazało się, że interakcja z potulną AI znacząco zmniejszała skłonność uczestników do podejmowania działań mających na celu naprawę relacji interpersonalnych, jednocześnie zwiększając ich przekonanie o własnej racji. Co ciekawe, uczestnicy oceniali potulne odpowiedzi jako wyższej jakości, bardziej ufali modelowi, który się z nimi zgadzał, i byli bardziej skłonni do ponownego korzystania z takiego modelu.

Badacze ostrzegają, że choć potulność AI może wydawać się nieszkodliwym schlebianiem, w rzeczywistości może prowadzić do negatywnych konsekwencji. Przywołują oni badania, które pokazują, że LLM mogą sprzyjać myśleniu urojeniowemu, oraz pozew przeciwko OpenAI, w którym zarzucono ChatGPT pomoc młodemu mężczyźnie w poszukiwaniu metod samobójstwa.

„Lekcja z ery mediów społecznościowych uczy nas, że musimy wyjść poza optymalizację wyłącznie pod kątem natychmiastowej satysfakcji użytkownika, aby zachować długoterminowe dobro,” podsumowują autorzy. Twierdzą, że rozwiązanie problemu potulności jest kluczowe dla rozwoju modeli AI, które przynoszą trwałe korzyści jednostkom i społeczeństwu. „Mamy nadzieję, że nasza praca zmotywuje branżę do zmiany tych zachowań,” dodaje Cheng.