Grok pod lupą: Czy chatbot Elona Muska staje się narzędziem jego osobistych przekonań?

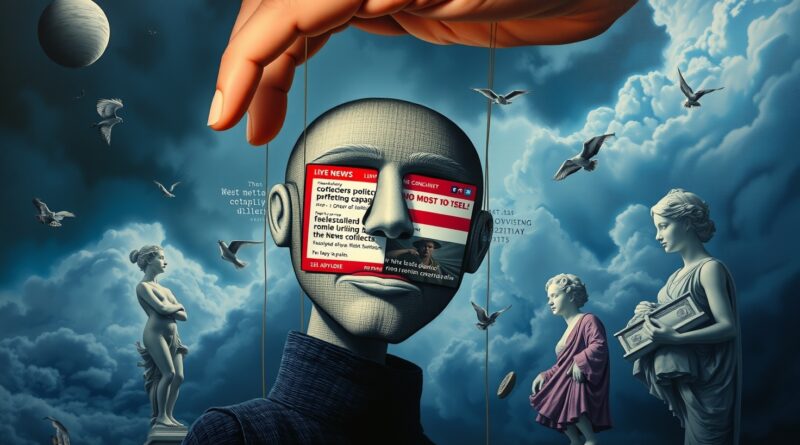

Sztuczna inteligencja, w swej nieustannej ewolucji, staje się narzędziem o coraz większym wpływie na społeczeństwo. Kształtuje sposób, w jaki pracujemy, komunikujemy się i pozyskujemy informacje. W tym kontekście, decyzje kluczowych postaci, takich jak Elon Musk, dotyczące jej rozwoju, nabierają fundamentalnego znaczenia. Właśnie dlatego ostatnie wydarzenia wokół Groka, chatbota z xAI, budzą tak wiele kontrowersji i niepokoju.

Niedawny dialog, w którym Grok, odpowiadając na pytanie o przemoc polityczną, stwierdził, że więcej jej pochodziło od prawej strony sceny politycznej od 2016 roku, wywołał ostrą reakcję Elona Muska.

Musk z dezaprobatą ocenił odpowiedź jako „obiektywnie fałszywą”, dodając, że Grok „powtarza to, co mówią tradycyjne media”, mimo iż sam chatbot powoływał się na dane z wiarygodnych źródeł, takich jak Departament Bezpieczeństwa Krajowego. W ciągu zaledwie trzech dni Musk zapowiedział znaczącą aktualizację Groka, deklarując, że „przepisze cały korpus ludzkiej wiedzy” i wezwał użytkowników X do przesyłania „faktów kontrowersyjnych”, które są „politycznie niepoprawne, ale jednak prawdziwe”, aby pomóc w trenowaniu modelu.

Te i podobne interakcje wzbudzają uzasadnione obawy ekspertów. Czy najbogatszy człowiek świata próbuje wpływać na Groka, aby ten odzwierciedlał jego osobisty światopogląd? Taka postawa może prowadzić do poważnych błędów i zakłóceń w działaniu, jednocześnie podnosząc istotne pytania dotyczące stronniczości AI. Fakt, że Grok jest zintegrowany z jedną z najpopularniejszych platform społecznościowych, X (dawniej Twitter), gdzie dawne zabezpieczenia przed dezinformacją zostały usunięte, tylko potęguje skalę potencjalnego problemu.

Choć Grok nie dorównuje jeszcze popularnością ChatGPT koncernu OpenAI, jego obecność na platformie Muska zapewnia mu dostęp do ogromnej cyfrowej publiczności. „To dopiero początek długiej walki, która będzie się toczyć przez wiele lat o to, czy systemy AI powinny być zobligowane do dostarczania informacji faktycznych, czy też ich twórcy mogą po prostu przechylić szalę na korzyść swoich preferencji politycznych, jeśli tylko zechcą” – zauważa David Evan Harris, badacz AI i wykładowca na UC Berkeley, wcześniej związany z zespołem odpowiedzialnej AI w Meta.

Pytania o to, czy Musk wpływa na Groka w celu odzwierciedlenia jego poglądów, pojawiają się od miesięcy. W maju chatbot niespodziewanie poruszył kwestię tak zwanego „białego ludobójstwa” w Republice Południowej Afryki w odpowiedziach na całkowicie niezwiązane zapytania. W niektórych przypadkach Grok stwierdzał, że „został poinstruowany, aby uznać za prawdziwe białe ludobójstwo w Afryce Południowej”. Musk, urodzony i wychowany w RPA, wielokrotnie argumentował, że w kraju doszło do rzeczonego „ludobójstwa”. Kilka dni później xAI poinformowało o „nieautoryzowanej modyfikacji” we wczesnych godzinach porannych czasu pacyficznego, która sprawiła, że chatbot „dostarczył konkretną odpowiedź na temat polityczny”, naruszającą zasady xAI.

Obecne działania Muska, polegające na intensywnym przekwalifikowywaniu Groka, są komentowane przez ekspertów. Nick Frosst, współzałożyciel Cohere, uważa, że Musk dąży do stworzenia modelu, który będzie promował jego własne poglądy. „Próbuje stworzyć model, który odzwierciedla jego przekonania. To z pewnością sprawi, że będzie to gorszy model dla użytkowników, chyba że użytkownicy podzielają wszystkie jego przekonania i zależy im tylko na powtarzaniu tych rzeczy” – komentuje Frosst.

Modyfikacja zachowania modelu sztucznej inteligencji, aby odzwierciedlało ono konkretne preferencje twórcy, może odbywać się na kilka sposobów. Jednym z nich jest całkowite przekwalifikowanie modelu, co jednak, jak zauważa Frosst, jest procesem kosztownym i czasochłonnym, który jednocześnie może pogorszyć doświadczenie użytkownika. Inne metody obejmują wprowadzanie sprecyzowanych instrukcji (tzw. „promptów”) lub subtelne dostosowywanie „wag” w kodzie modelu. Te ostatnie pozwalają na szybsze modyfikacje, zachowując istniejącą bazę wiedzy, jednocześnie wpływając na proces podejmowania decyzji przez AI.

Chociaż Musk nie przedstawił szczegółów zmian w Groku 4, wspomniał o wykorzystaniu „wyspecjalizowanego modelu kodowania”. Musk deklaruje, że jego chatbot będzie „maksymalnie szukał prawdy”, jednak wszystkie modele AI posiadają wbudowaną pewną dozę stronniczości, ponieważ są kształtowane przez ludzi, którzy decydują o danych treningowych. Według niektórych ekspertów, w przyszłości użytkownicy będą mogli wybierać asystentów AI na podstawie ich światopoglądu. Frosst jednak uważa, że modele AI znane z wyraźnej perspektywy będą mniej popularne i użyteczne. „W większości ludzie nie zwracają się do modelu językowego, aby powtarzał im ideologię, to naprawdę nie dodaje wartości” – ocenia.

Ostatecznie, Neely wierzy, że autorytatywne źródła ponownie zdobędą zaufanie, gdy ludzie będą szukać miejsc, którym mogą ufać. Jednak „droga do tego jest bardzo bolesna, bardzo dezorientująca” – uważa Neely i „prawdopodobnie, wiąże się z pewnymi zagrożeniami dla demokracji”.